Blog

L’analyse prédictive avec Cortana Analytics

Cortana Analytics, Kezako ?

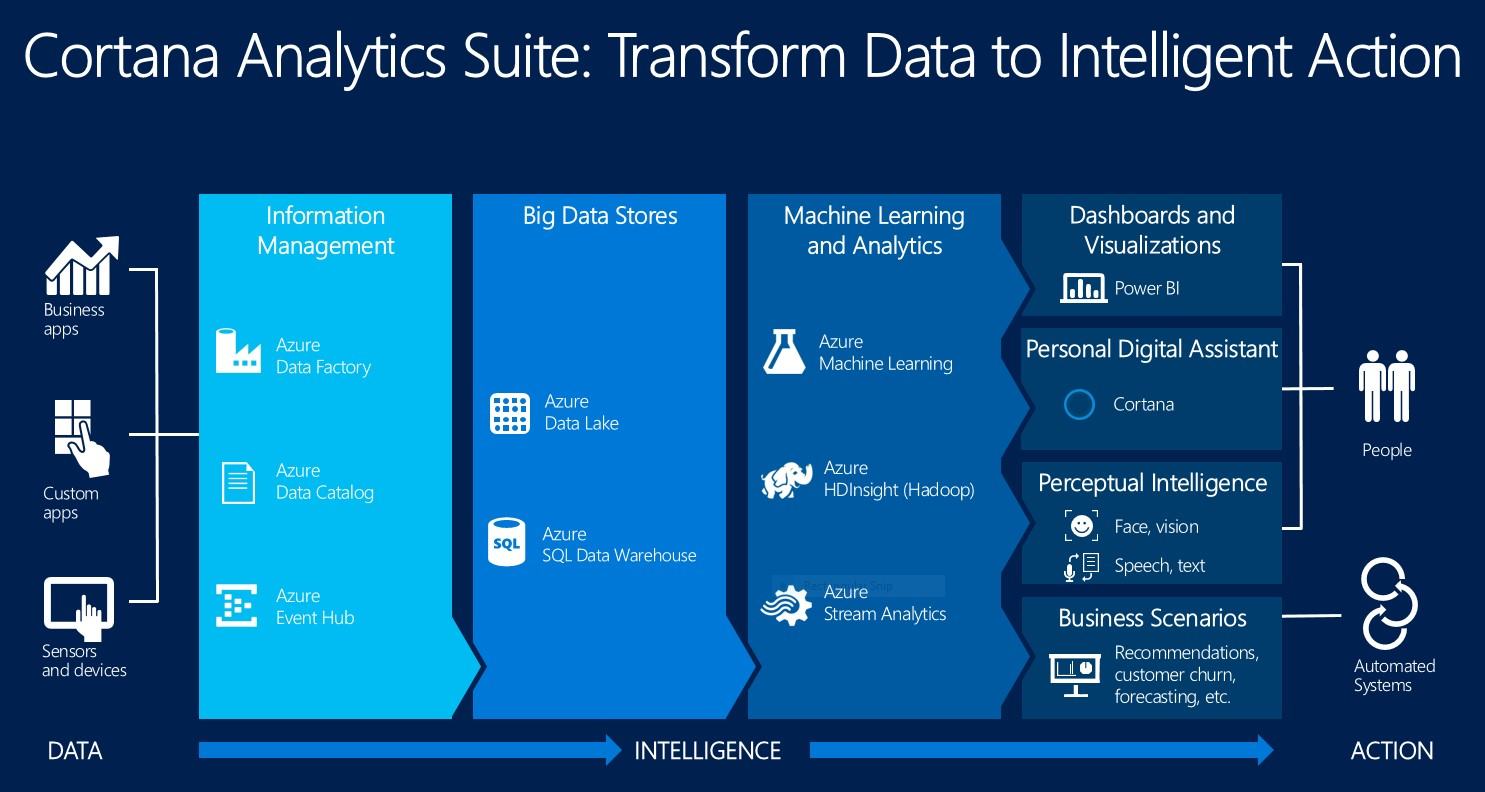

10 juin, j’assiste à l’atelier Cortana Analytics chez MS. C’est un ensemble de services dont la finalité est de faire de l’analyse prédictive depuis Azure, en d’autres termes d’identifier des patterns pour anticiper des comportements et des usages. Voici la catalogue de services qui composent la suite Cortana Analytics (non exhaustif), en bleu ceux que nous avons exploités pendant l’atelier :

- Data Factory : ETL, Extract Transform and Load data

- Data Catalog : Catalogue de métadonnées pour décrire des référentiels (Data Stewart)

- Event Hub : Concentrateur d’événements

- Data Lake : Traitement de données par job en U-Sql (langage hybride C#/TSQL) pour interroger des données (ex : fichiers) sur une architecture distribuée

- SQL Data Warehouse : Base de données permettant le traitement de gros volumes de données structurées ou pas

- HDInsight : Couche Microsoft par dessus Hadoop

- Machine Learning : Analyse prédictive

- Stream Analytics : Moteur de traitement d’événements en temps réel

Cortana Analytics en image :

Hadoop pour rappel est une architecture distribuée open source développée en java permettant le stockage, le traitement et l’analyse prédictive de données en accord avec la règle des 3V :

- Volume : données générées par des entreprises ou des personnes dont la croissance est exponentielle

- Vélocité : vitesse de génération, de capture et d’analyse des données

- Variété : format de données divers, structurée et non structurée

Première partie de l’atelier

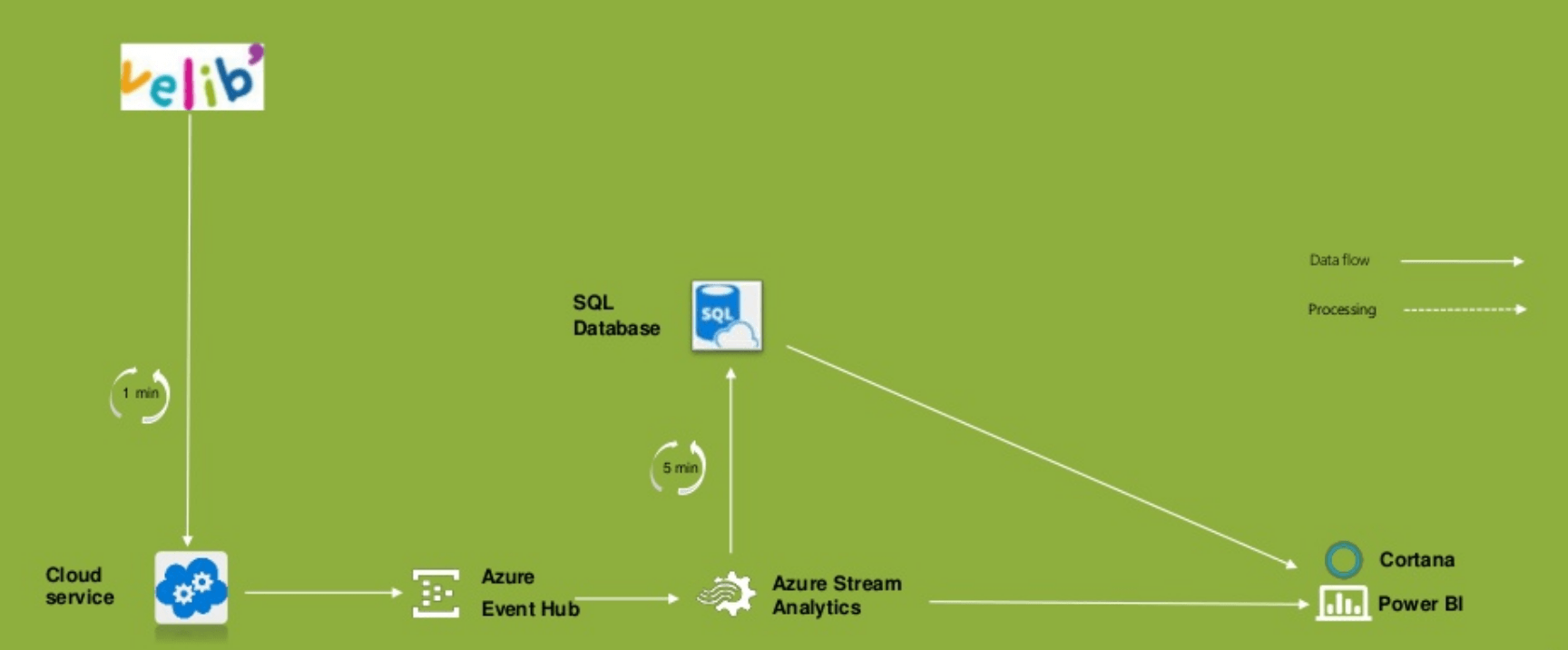

On est accueillis avec le petit déjeuner, pas trop nombreux, on se présente à tour de rôle et on démarre le TP tranquillement. On nous fournit une solution Visual Studio toute faite à déployer avec un tutoriel pour paramétrer des services Azure. Pour résumer, on publie une application C# dans Cloud Service en mode Worker (tâche de fond) qui interroge en boucle une API JCDdecaux mettant à disposition un flux Json sur la disponibilité des Vélibs et on envoie les infos sous forme d’évènements à un récepteur EventHub. Ces évènements alimentent un rapport Power BI et une base Azure SQL Database en sortie via un job Stream Analytics.

Fin de la première mi-temps, plus concrètement le projet prend cette forme en fin de matinée :

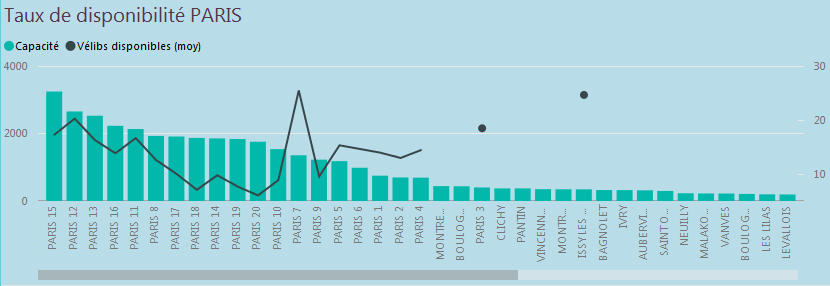

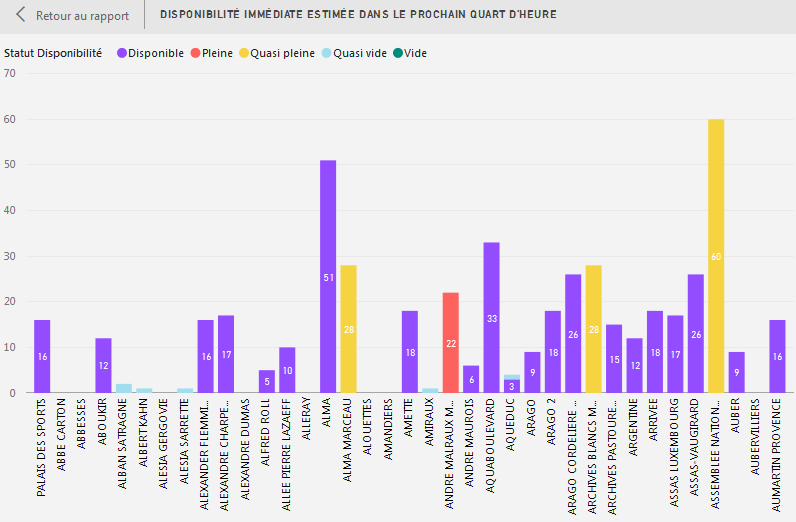

Nous avons un rapport qui affiche les infos de disponibilités des Vélibs en temps réel par arrondissement, pour un emprunt ou une restitution. On pourrait s’arrêter là….

Deuxième partie de l’atelier

La session reprend mais avec un nouvel intervenant, très discret jusqu’à maintenant, le Data Scientist, Yassine Khelifi, qui est en charge de l’analyse de « données massives » (Big data). Pour résumer, les premiers mots que Yassine a prononcé, ne sont ni papa, ni maman mais une formule mathématique. Le gars a aussi inventé le principe de la turbine pour les centrales nucléaires quand il était petit, avec son biberon ! Le temps d’apprendre à marcher pour se rendre à l’INPI, à peine arrivé au guichet, grosse déception, un autre type avait déposé le brevet avant lui.

Le but ultime de cet atelier n’est pas la BI traditionnelle basée sur des moyennes, des min. et max. depuis le cloud Azure, mais la prédiction. Et c’est là qu’intervient Machine Learning destiné à l’apprentissage automatique avec la mise en place d’algorithmes ! C’est dans le service du même nom dans Azure que les Data Scientist vont créer leurs modèles prédictifs et générer des prédictions avec le langage R, à partir de formules mathématiques.

Voici quelques informations issues de ce blog sur le Machine Learning : http://www.jeveuxetredatascientist.fr/quest-ce-que-le-machine-learning/

Le Machine Learning se décompose en 2 étapes : une phase d’entrainement (on apprend sur une partie des données) et une phase de vérification (on teste sur la seconde partie de données).

Nous aurons donc 3 phases : la Représentation / l’Évaluation / l’Optimisation. La phase de représentation consiste à trouver le modèle mathématique le plus adapté. Il existe un nombre important de modélisations. Enfin, l’évaluation mesure l’écart entre le modèle et la réalité des données de tests. L’optimisation vise à amenuiser cet écart.

Nous pouvons dénombrer 3 méthodes basiques :

- Classification : modélisation de plusieurs groupes de données dans des classes existantes. Par exemple : la classification des cactus, la tendance d’un parti politique…

- Clustering: ressemble à la classification mais ce ne sont pas des classes connues. Typiquement un système de recommandation de films.

- Régression: les données sont liées à d’autres données numériques par une corrélation (une droite, une courbe, une tendance).

Machine Learning en pratique :

- Voiture autonome de Google

- Classification des emails dans gmail

- Traduction en temps réel de Skype

- Détection de fraude dans le monde de la banque

- Reconnaissance faciale

- Reconnaissance vocale Siri d’Apple

Machine Learning illustré :

Merci à Gillou pour cette illustration : http://www.commitstrip.com/fr/2016/07/05/bot-bot/

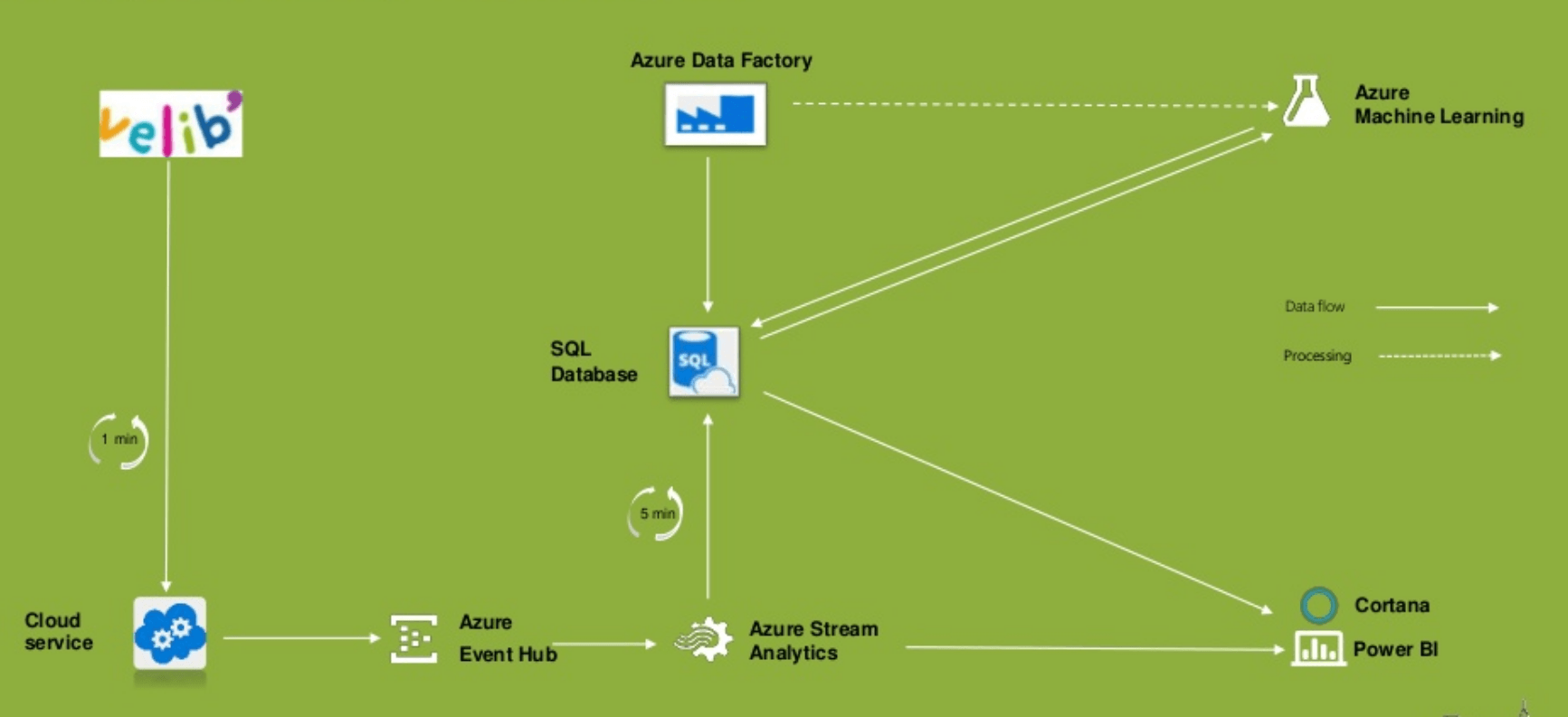

Une fois que le modèle prédictif est défini, on va secouer le tout avec Azure Data Factory : donc récupérer les données en entrée à partir de Azure SQL Database, appliquer le modèle prédictif en R sur ces données et enfin consommer le résultat/prédiction dans un rapport Power BI en sortie.

Fin de la seconde mi-temps, on en est là :

Mais qu’est-ce qu’on obtient à l’arrivée ? Sur la base d’un modèle prédictif, un rapport qui prédit la disponibilité des Vélibs dans chaque station, pour un emprunt ou une restitution. Bref, on n’affiche plus l’état des stations à un instant T, on le prédit.

Conclusion

L’atelier nous a donné une bonne vision d’ensemble des services rendus dans Azure sur la partie BI, en sachant que plus globalement la plateforme évolue très rapidement. C’est quand même bien pensé : tout est fait pour nous maintenir dans le cloud, un peu à l’image d’Office365. Vous n’avez plus à vous soucier de rien sauf du coût. Cela étant quand il s’agit de confidentialité des données, certaines entreprises ne peuvent pas avoir recours au cloud public. La prise en charge du langage R OnPremise sur SQL Server 2016 est donc un atout supplémentaire. Au cours de cet atelier, on a été bousculé mais dans le bon sens du terme. La BI traditionnelle prend un sacré coup de vieux et la prédiction est un autre métier. En toute honnêteté, je serai incapable de commenter les modèles prédictifs que Yassine le Data Scientist nous a décrit (voir sources), un peu comme le jour où j’ai tenté d’expliquer la BI à mon mon chat, c’est peine perdue :

Sources

L’ensemble de la solution a été détaillé, y compris les analyses prédictives :

- Première partie : https://blogs.msdn.microsoft.com/big_data_france/2016/03/25/velib-cortana-analytics/

- Deuxième partie : https://blogs.msdn.microsoft.com/big_data_france/2016/03/29/velib-cortana-analytics-2/

- Troisème partie : https://blogs.msdn.microsoft.com/big_data_france/2016/04/12/velib-cortana-analytics-3/

Il y a eu également une session au SQLSat 2016 le 25 juin animée par les mêmes acolytes, Romain Casterès et Yassine Khelifi, les slides sont disponibles à cette adresse :

Blog Data Scientist :

http://www.jeveuxetredatascientist.fr/quest-ce-que-le-machine-learning/

G.O du club Cortana Analytics

Emilie Beau, c’est un des Power Rangers (techdays 2014), à vous de deviner lequel au jeu des différences… Toujours à la rescousse des plus faibles sur Twitter @BIwithEmilie.

Romain Casterès, fan de Ti-punch et Frankie Vincent à ses heures perdues et régulièrement sur Twitter @PulsWeb.

Pas de dossier sur Yassine Khelifi (jamais une amende, pas une beuverie, une photo honteuse sur Facebook, rien)… MAIS vous pouvez le suivre sur Twitter @datashinobi.

BRAVO à tous les 3 !

Auteur

- Archietcte Data Microsoft, les maîtres mots sont : performance, industrialisation, méthodologie & bonne humeur.

Derniers articles

- 2019.12.02BI & Big DataEtude des contextes en DAX (4/4) : Transition de contexte

- 2019.11.25BI & Big DataEtude des contextes en DAX (3/4) : Contexte de requête

- 2019.11.17BI & Big DataEtude des contextes en DAX (2/4) : Contexte de filtre

- 2019.11.11BI & Big DataEtude des contextes en DAX (1/4) : Contexte de ligne